Un modelo de lenguaje a gran escala, conocido por sus siglas en inglés como LLM, tiene como misión crear texto como si fuera una persona real, aunque a veces sorprenda por superar las expectativas iniciales. Esta tecnología resulta impresionante porque cambia incluso la forma en que trabajamos o buscamos respuestas en el día a día, ya que utiliza cantidades colosales de datos para crecer y transformarse en una herramienta que, de verdad, está influyendo absolutamente en nuestra relación con la información y las máquinas. Y mientras algunos la ven como el futuro, otros ya la consideran indispensable.

¿Qué es exactamente un modelo de lenguaje (LLM) y cómo funciona?

Por cierto, un modelo de lenguaje a gran escala, el famoso LLM, es en esencia un sistema de inteligencia artificial que explora patrones y relaciones en terabytes de textos recopilados. Lo hace a través de millones de parámetros que terminan almacenando todo lo que ha aprendido, aunque esa "comprensión" no sea idéntica a la mente humana. Lo que realmente trata de conseguir es entender el lenguaje y proponer respuestas útiles y poco forzadas en cada ocasión. Los tecnólogos que diseñan estos modelos ajustan incansablemente esas variables internas para lograr que los resultados sean no solo adecuados, sino cada vez más precisos.

La arquitectura transformer: el motor de los LLM

Ahora, lo que verdaderamente da potencia a los LLM actuales es la famosa arquitectura Transformer. Desde su aparición en 2017, logró que el tratamiento de frases no sea una fila interminable, sino una especie de sala donde todas las palabras conversan a la vez. ¿Cómo lo hace? Usando la auto-atención, un mecanismo cuyo nombre suena técnico, pero que actúa casi como un director de orquesta que hace que cada palabra se fije en lo que ocurre alrededor, sin perder la melodía principal, claro está. Así, el Transformer se desembaraza de la antigua costumbre de procesar una palabra tras otra, logrando identificar relaciones detalladas en cualquier punto de la frase, incluso si están lejos.

- Capas de auto-atención multi-cabeza: Son como mentes paralelas detectando distintos matices y relaciones entre palabras en cada oración, algo que ayuda al modelo a no perderse en los detalles irrelevantes.

- Redes feed-forward: Actúan puliendo los datos tras el torbellino de la atención, asegurándose de que lo que pasa por cada palabra resulte inteligible para el sistema.

- Codificación posicional: Porque en el caos del procesamiento paralelo, es fundamental no olvidar quién llegó antes o después en la secuencia de texto; de ahí esta capa que da pistas sobre el lugar de cada término.

Seguro que has oído hablar de nombres como BERT o GPT. De la base de esta arquitectura han surgido variantes casi especializadas:

- BERT: perfectísimo para entender lenguaje, porque contiene mayormente la parte del codificador, como ese amigo que siempre tiene claro lo que quieres decirle.

- GPT: pensado con el decodificador como protagonista; sobresale generando texto, palabra tras palabra, improvisando como un narrador creativo.

- T5: reúne ambas partes y se adapta a múltiples tareas con soltura casi camaleónica.

De la teoría a la práctica: cómo aprende un LLM

Al pasar a la acción, el LLM se entrena repitiendo hasta la saciedad el ejercicio de predecir la próxima palabra en un fragmento de texto. Esta rutina, que puede parecer trivial, es lo que le permite absorber las reglas y peculiaridades del idioma. Pero, claro, una vez que ese aprendizaje básico termina, el modelo puede "afinarse" siguiendo instrucciones muy concretas (conocidas por el nombre popular de prompts), o bien recibir un entrenamiento extra para tareas singulares.

| Característica | Transformer (base) | LLM (Ej. GPT-3) | GPT-5 |

|---|---|---|---|

| Capas (Cod/Decod) | 6 / 6 | Numerosas capas | Solo decodificador |

| Cabezas de atención | 8 por capa | Múltiples por capa | Más de 100 |

| Dimensión de vectores | 512 | Mucho mayor | 12.288 |

| Número de parámetros | ~65 millones | Hasta 175.000 M | 100k millones |

Lo cierto es que, a pesar de sus progresos, los modelos pueden fallar al dar sentido a frases ambiguas. Aquí es donde interviene el arte de formular las preguntas o indicaciones, en lo que muchos llaman prompt engineering; una labor que, cuando se realiza bien, hace que el LLM brille ofreciendo respuestas ajustadas al contexto de manera sorprendente.

¿Con qué datos se entrena un LLM para que sea tan potente?

A la hora de entrenar un LLM, el éxito depende en gran parte de los datos con los que se le alimenta. Por eso, quienes diseñan estos sistemas calibran cuidadosamente el tipo y la cantidad según si buscan un modelo generalista o muy enfocado en un tema. Es un poco como preparar la despensa mejor surtida posible, pues de su variedad y calidad dependerá el resultado.

Datos especializados para tareas concretas

En áreas donde el razonamiento es crucial o se requiere tutoría inteligente, los responsables del entrenamiento seleccionan conjuntos de datos reducidos, pero sumamente específicos. Algunos ejemplos realmente interesantes:

- Symbolic propositional logic (SPL): Enseña a los modelos a traducir textos en símbolos y construir largas cadenas de razonamiento, como si dieran clases de lógica pura.

- Logic tutor (LT): Con problemas progresivos que ayudan a que el modelo aprenda, poco a poco, a enfrentarse a situaciones cada vez más complicadas.

- Problem solving states (PSS): Basado en interacciones reales con estudiantes, permitiendo que el modelo ofrezca sugerencias casi hechas a medida.

En estos contextos, suele ser suficiente mostrarle al modelo solo un puñado de ejemplos antes de retarle con nuevos desafíos, aprovechando técnicas como el few-shot learning que se ha puesto bastante de moda por su eficiencia.

Datos masivos para modelos generalistas

Curiosamente, para los modelos generalistas como GPT-4 o el nuevo 5, la receta cambia radicalmente. La mezcla de datos proviene de fuentes tan gigantescas como:

- Common Crawl: El gran océano de textos de la web pública, donde el modelo pesca la mayoría de sus recursos.

- WebText2: Fragmentos seleccionados de páginas valoradas por su nivel y calidad.

- Corpus de libros (Books1 y Books2): Obras literarias y textos de no ficción, que aportan profundidad y contexto variado.

- Wikipedia: Que aunque solo supone una pequeña parte, ofrece información bien estructurada y fácil de validar.

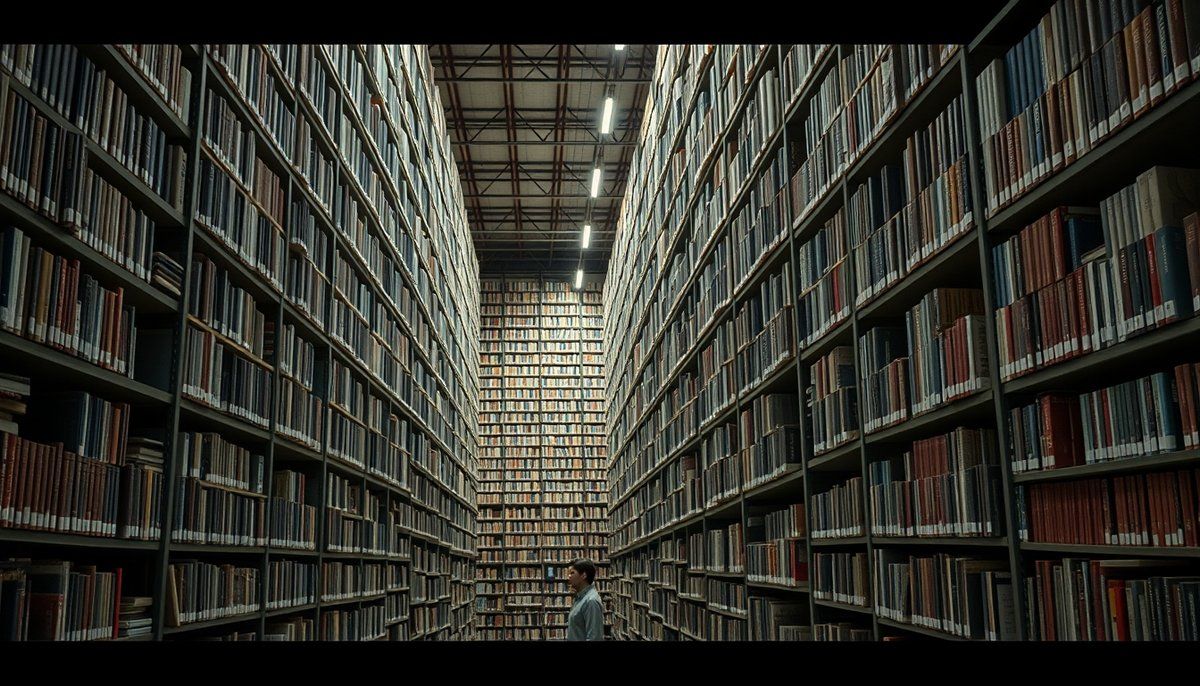

Reuniendo todo, y tras filtrar lo redundante y la "paja", el modelo acaba entrenado con cerca de 500.000 millones de tokens. Algo así como tener a tu disposición la biblioteca casi infinita de Borges, pero mejor organizada y sin polvo.

Para GPT-5 se comenta que se ha entrenado con datos sintéticos creados por otros modelos.

La importancia del equilibrio: las "leyes de escala"

Un aspecto vital y no siempre bien apreciado es equilibrar la cantidad de datos, el tamaño del modelo y los recursos disponibles. Las llamadas "leyes de escala" muestran que, aunque aumentar parámetros ayuda, hacerlo de forma desmedida tiene un límite. Por ejemplo:

- Cada vez que agrandas el modelo, la mejora es menos espectacular que la vez anterior.

- Sumar más datos tampoco garantiza saltos exponenciales en el rendimiento, y el retorno comienza a hacerse lento.

- Invertir en computación mejora el sistema, pero se nota menos cuando se cruza cierto umbral.

En esencia, lo inteligente es hallar el balance justo. Así, para escalar un modelo ocho veces, solo necesitas multiplicar por cinco la cantidad de datos, sin disparar costes ni esfuerzos. Esto explica por qué los modelos realmente grandes ahora suelen aprender rápido con muy pocos ejemplos, adaptándose más y mejor a nuevos retos.

¿Para qué se usan los LLM en el mundo real?

Difícil negar que los LLM han dejado ya huella en muchos sectores. No es raro ver que las empresas los integran entusiasmadas, sobre todo porque pueden comprender y producir lenguaje natural en contextos que hace poco parecían reservados a expertos humanos.

Revolucionando la educación y las tutorías inteligentes

Dentro del ámbito de la educación, y especialmente en las áreas STEM, los LLM están cambiando el panorama al hacer que los sistemas de tutoría sean increíblemente precisos. Estos sistemas, que antes dependían de costosos desarrollos manuales, ahora responden a las dudas de los estudiantes en tiempo real y de forma personalizada. Ejemplos como DeepSeek-V3, GPT-4o o el nuevo GPT-5 parecen casi profesores expertos, capaces de desglosar problemas paso a paso o diseñar pistas adaptadas a cada usuario.

Además, no es exagerado decir que los LLM están facilitando la creación de materiales educativos. Véase exámenes, resúmenes, explicaciones: todo a medida y para todos los niveles posibles, algo que hace apenas unos años era impensable para la mayoría de los centros educativos.

Simulando el comportamiento humano en finanzas y derecho

En el mundo financiero, muchas entidades recurren a los LLM para simular mercados o explorar conductas económicas antes de tomar decisiones importantes. Al generar agentes que piensan y actúan como inversores o consumidores, logran prever consecuencias de políticas o estrategias empresariales. Lo mismo ocurre en el terreno legal, donde resulta posible planificar e interpretar el impacto de nuevas normas sin salir de la simulación.

Eso sí, aún queda camino por recorrer porque mantener la coherencia y evitar resultados parciales sigue siendo complicado. Las simulaciones pueden tener fallos, sobre todo en la consistencia de "personalidades" de los agentes simulados.

Apoyo en el sector sanitario

También en la salud, los LLM están aportando un valor añadido que no debería subestimarse. Por ejemplo:

- Generación de informes clínicos: Los profesionales médicos están automatizando la redacción de informes, como los radiológicos, ahorrando tiempo y evitando errores comunes.

- Triaje hospitalario: El modelo puede clasificar casos médicos según la urgencia, agilizando la atención inicial en situaciones de crisis.

- Educación para pacientes: Muy valioso, ya que facilita la explicación de diagnósticos y tratamientos mediante textos claros y personalizados.

El obstáculo principal, claro, es que el modelo no puede "inventarse" datos ni ofrecer errores peligrosos, lo que se conoce como "alucinaciones". Asegurar la fiabilidad clínica es esencial y obliga a supervisar cada implementación con extrema atención.

¿Cuáles son los límites y fallos técnicos de los LLM?

A pesar del bombo y platillo, los modelos LLM no son infalibles. De hecho, quienes los usan deben estar al tanto de notables limitaciones. Las dificultades van desde fallos internos en su arquitectura, hasta los elevados costes que implica su operación diaria.

Uno de los defectos más frecuentes es la inconsistencia en la simulación del comportamiento humano: mientras el modelo puede decir que va a actuar de cierta manera, en los hechos suele comportarse como alguien totalmente diferente, lo que introduce desconfianza en sus aplicaciones sociales, económicas e incluso psicológicas.

- Sesgos heredados: Arrastran prejuicios y errores puestos en los textos de los que han aprendido, a veces de forma muy evidente.

- Falta de consistencia a largo plazo: Cuando la conversación se alarga, pueden perder el contexto y desviarse del tema inicial.

- Comprensión superficial: Porque su lógica, así nos pese, es estadística, no la de un pensador humano consciente; los LLM no planean ni reflexionan con intencionalidad real.

Por otra parte, diseñar y validar simulaciones lleva más trabajo del que parece. Si los escenarios creados no reflejan la vida real al menos en lo básico, las conclusiones serán todo menos útiles. Por último, el coste energético y operativo puede ser absolutamente desbordante, al punto de estar al alcance de solo unos pocos gigantes tecnológicos y aumentando la huella ecológica del sector.

¿Qué riesgos éticos y de seguridad presentan los LLM?

Al margen de lo técnico, no podemos olvidar que la ética y la seguridad están en la mira cuando se habla de LLM. Es fundamental atender estos aspectos para evitar consecuencias negativas de su uso irresponsable.

Sesgos y falta de autenticidad

Estas herramientas pueden, muy fácilmente, reforzar y multiplicar sesgos sociales y demográficos presentes en los textos que han servido de base para su entrenamiento. Los ejemplos abundan: desde asignar profesiones en función del género hasta reflejar prejuicios culturales o religiosos muy evidentes. Aplicar LLM sin filtros en recursos humanos, salud o educación podría, sin querer, cristalizar desigualdades.

Por otra parte, los modelos tienden a reproducir una moral homogénea, lo que termina eliminando la riqueza de matices que caracteriza a las personas. Esta uniformidad puede desvirtuar estudios sociológicos y experimentos en ciencias sociales que buscan, precisamente, reflejar la diversidad real.

Transparencia y fiabilidad

Resulta preocupante la poca claridad con la que los LLM exponen sus decisiones. El célebre problema de la "caja negra" hace que, a veces, nadie sepa por qué llegaron a ciertas conclusiones, complicando la vigilancia y aumentando las probabilidades de errores o sesgos. Sin transparencia, la confianza pública y científica corre serio peligro, especialmente si se usan en decisiones importantes.

¿Cómo se pueden mitigar estos riesgos?

Hay propuestas en marcha para evitar problemas mayores, entre las que destacan:

- Mejorar el entrenamiento: Ampliar y auditar las bases de datos para controlar los sesgos y diversificar las fuentes.

- Implementar marcos de validación: Corroborar los resultados con personas expertas y realizar contrastes continuos con casos del mundo real.

- Fomentar la auditoría y la transparencia: Explicar de dónde provienen los datos y detallar las limitaciones, facilitando la revisión por terceros.

- Mantener la supervisión humana: No dejar en manos del LLM decisiones críticas, sino asegurar que siempre haya una persona interviniendo en las fases esenciales.

Definitivamente, los modelos de lenguaje han abierto una puerta a nuevas formas de entender y utilizar la información. Pero cuanto más pudieron las máquinas, más responsabilidad implican. Si no se atienden los riesgos éticos, los sesgos y la falta de claridad, todo ese potencial podría volverse en contra de la equidad y la confianza pública.

Así que, aunque el avance técnico seguirá marcando el ritmo, el futuro de los LLM dependerá, en última instancia, de lo que decida la comunidad experta, los legisladores y la propia sociedad. Crear reglas claras y consensuadas será el camino para que la inteligencia artificial contribuya, de verdad, al avance colectivo y no solo al interés privado de unos pocos.